2 月 16 日凌晨,OpenAI 在官网博客中介绍了最新的 AI 模型——文生视频模型 Sora,它可以根据人们的文本描述生成原始视频。

在放出的演示视频中,Sora 可以生成清晰准确的角色,远景、近景交错但主题一致的视频,并且,已经能一次性生成最长 60s 的视频。看着这些视频,AI 根据剧本自动生成好莱坞电影,似乎已经向我们走来。

一经发布,社交平台 X 上,和 AI 以及视频相关的创业者坐不住了。

YouTube 头部网红 MrBeast 回应 Sam Altman 发布 Sora 模型的推特时,打趣道:Sam,请不要让我无家可归。

Runway 联合创始人、CEO Cris Valenzuela 发推称:比赛开始了。

但 OpenAI 没有拘泥于在花哨的视频本身中,对于 Sora 文生视频,OpenAI 表示:这是通向 AGI 的里程碑事件。

01 60s、语言理解、物理世界交互

据 OpenAI 官网,Sora 模型的目标是「理解和模拟运动中的物理世界」。当前,它的最大亮点是可以生成长达 1 分钟的视频,并且,在这 1 分钟的视频中,可以保证视觉质量,遵守用户提示词。举例来说,Sora 可以生成一系列复杂场景的视频,包括多个角色、特定类型的运动、以及在特定主题和背景下的精确细节等。

输入如下提示词,Sora 生成的视频:美丽、白雪皑皑的东京城市熙熙攘攘。镜头穿过熙熙攘攘的城市街道,跟随几个人享受美丽的雪天,在附近的摊位上购物。绚丽的樱花花瓣随着雪花在风中飞舞。|来源:OpenAI

Sora 模型根据提示词,可以生成如此程度的准确视频,意味着它对语言的理解能力出众。

它不仅理解用户在提示词中想要什么,还理解这些东西应该如何在物理世界中存在。相应地,Sora 可以基于对提示词的理解,精确阐述、演绎提示词,生成恰当的角色来表达极具张力的情绪。

如下提示词 Sora 生成的视频:一个美丽的自制视频,展示了 2056 年尼日利亚拉各斯(Lagos)的人们,用手机相机拍摄的。|来源:OpenAI

在一众的演示视频中,你会发现,Sora 还可以在一个生成的视频中创建多个镜头。不仅如此,即便在近景、远景、不同角度的镜头下,也能保持角色和视觉风格的一致性。

当然,OpenAI 也在官网承认,Sora 还远非完美。它可能难以准确地模拟复杂场景下的物理世界,也可能无法理解一些场景下的因果关系,比如,一个人可能咬了一口饼干,但之后,饼干上可能没有咬痕。

此外,Sora 还可能混淆提示词里诸如「左、右」一样的空间细节,并且可能难以精确描述随时间发生的事件。

OpenAI 没有透露 Sora 模型何时公开,但表示将与有限数量的外部人士分享。当地时间 2 月 15 日一整天,OpenAI CEO Sam Altman 都在他的 X 社交媒体账户上发布 Sora 生成的视频。他让粉丝给出提示词,他发布该提示词下 Sora 生成的视频。

OpenAI 称,尽早分享研究进展是为了与外界展开合作、获得反馈,也让公众了解 AI 的进展。「我们也让一些视觉艺术家、设计师和电影制作人访问,以获得推进该模型以对创意专业人士最有帮助的反馈」。

除此之外,用来评估 Sora 危害或风险的「红队」(red teamers)可以提前测试该模型。这里的红队是指,错误信息、仇恨内容和偏见等领域的专家,他们将对抗性地测试该模型,从而评估如何防止 Sora 被滥用来制造错误信息或其他有害内容。

OpenAI 表示,在把 Sora 应用于 OpenAI 的产品之前,将采取一些重要的安全措施。

02「物理世界 GPT」

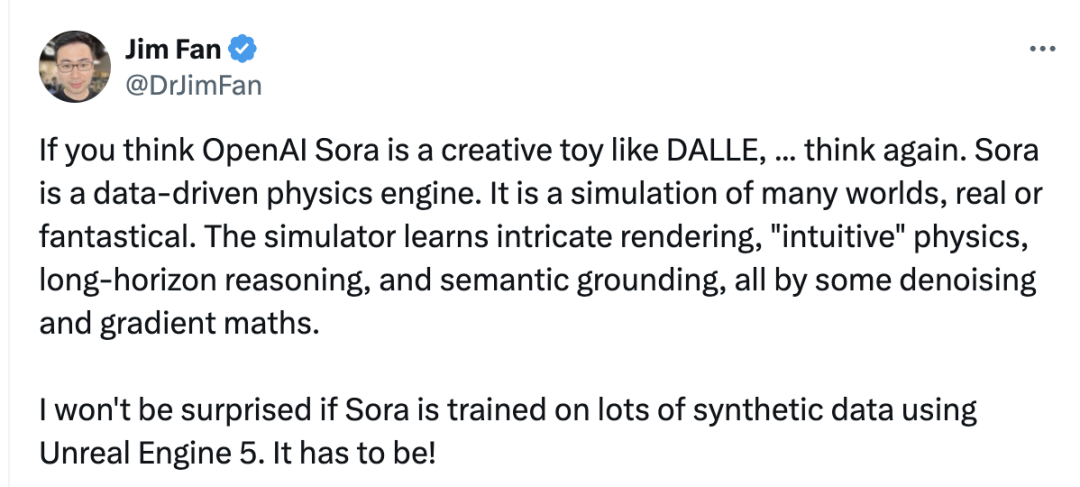

官方博客中,OpenAI 称 Sora 的目标是「理解和模拟现实」,这也是是英伟达 Omniverse 多年来押注的未来。看到 Sora 的能力,英伟达高级科学家,AI Agent 负责人 Jim Fan 盛赞其强大模型背后的技术突破。

Jim Fan 在 X 社交媒体发表上述观点|来源:twitter.com

他称,「如果你认为 OpenAI Sora 是一个像 DALLE 一样的创意玩具……再想想。Sora 是一个数据驱动的物理引擎,是对现实或幻想世界的模拟。这一模拟器通过去噪和梯度数学,来学习复杂渲染、『直觉』物理(「intuitive」physics)、长视野推理(long-horizon reasoning)和语义基础。」

在其背后的技术实现上,Jim Fan 认为,Sora 一定使用了 Unreal Engine 5 生成的大量合成数据来训练。

在技术声明中,OpenAI 尚未介绍 Sora 模型的训练数据等细节,称将在 2 月 16 日晚些时候,发布技术论文。

在已公布的信息中,Sora 是一个扩散模型,从一个看起来像静态噪声的视频开始,通过许多步骤去除噪声来逐渐形成最终视频。并且,Sora 能够一次性生成整个视频,或者扩展已生成的视频使其更长。

OpenAI 称,通过赋予模型一次预测许多帧的能力,解决了一个具有挑战性的问题,即确保一个主题即使暂时消失在视野之外也保持不变。

与 GPT 模型类似,Sora 使用 Transformer 架构,具备卓越的缩放性能。

对于 Sora 模型的重要意义,OpenAI 在官方博客结尾指出,「Sora 作为能够理解和模拟现实世界的模型基础,我们相信这一能力将是实现 AGI 的重要里程碑。」

显然,OpenAI 的目标依旧是 AGI 的实现,在这个恢弘的目标下,其在集结资源和自身能力上的领先优势,又一次体现出超越一般创业公司的综合实力。

此前,Pika 联合创始人 Demi Guo 在接受极客公园的采访时表示,在文生视频赛道,相比基于现有模型能力做功能优化、打补丁,模型能力本身才是决定文生视频产品成败最关键的因素。

一经发布,OpenAI 的 Sora 模型再次刷新 AI 文生视频的超能力,显然对这个赛道那些已经发布产品的初创公司形成了巨大压力:Runway、Synthesia、Pika、Rephrase.ai……

就像 Runway 联合创始人、CEO Cristóbal Valenzuela 在几个小时前说的那样:比赛开始了。

其实,这句看起来「不服输」的话,并不准确。Sora 的出现,让「视频生成赛道」基于上一代模型技术的产品比赛,已经结束了。现在开始的,将是一场全新的技术比赛,而不只是产品的比拼。

最新评论

苹果如果不支持微信,那它就是要退出中国市场了!

自己花钱买的座位,凭什么不能换?

不得不说蓝心妍很漂亮,我喜欢!

人间胸器

去了美颜滤镜,估计就是大妈了!

期待,不过感觉自己可能用不上了!

天涯不是彻底关闭了吗?

感觉长想一般般!