「疯球了,彻底疯球了!」

「这是什么?泰勒·斯威夫特的演唱会吗?」

当地时间 3 月 18 日中午,美国加州圣何塞 SAP 体育中心,超过万人的冰球体育馆内座无虚席。

这是 2024 年英伟达的 GTC 大会现场,人们等待的并不是 1 米 80 的白人女星,而是一位身穿皮衣的亚裔中年男性——英伟达创始人兼 CEO 黄仁勋。

15 个月内市值暴涨 6 倍至超过 2 万亿美元,成为继苹果和微软之后的全球第三大科技公司,并且仍然看不到增长的天花板——是的,从某种意义上看,黄仁勋可能比斯威夫特更像一个「摇滚巨星」。

时隔 5 年再度回归线下的 GTC,现场爆满。开场,老黄打趣道:「你要意识到,这不是一场演唱会,而是一个开发者大会」。面对「粉丝」的热情欢呼,黄仁勋也不禁用调侃作为开场白。

很难想象能有一个会议容纳如此多不同行业背景的人,从气候技术到无线电科学、从机器人到自动驾驶、从 IT 业到非 IT 业。「坐在这个会场里的你我他,代表世界上 100 万亿美元的行业」。

而把如此多行业和英伟达缔结联系的,正是 AI。以大语言模型为核心的 AI 正在席卷几乎所有行业,英伟达为各行各业的 AI 变革提供算力引擎。

两万亿美元市值如何「坐实」、如何用算力继续推送新一波的 AI 浪潮、更重要的是,英伟达如何成为「新计算时代」的王者?面对这些巨型问题,今年的这场 GTC 大会对于英伟达来说,尤其重要。

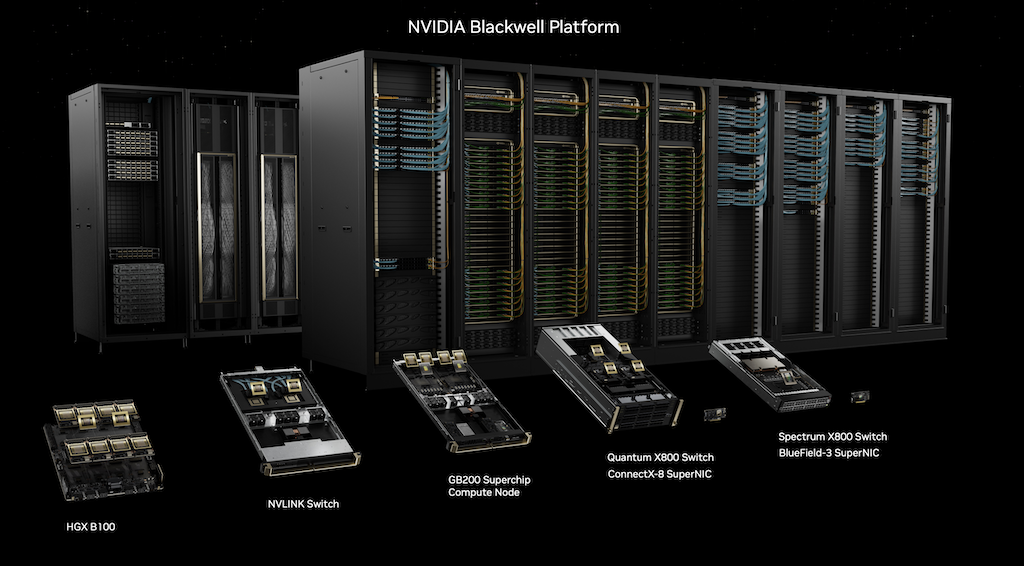

英伟达最新的 GPU 产品系列|图片来源:Nvidia

在长达 2 小时的开场演讲中,黄仁勋介绍了当下爆火的 AI 背后,英伟达准备好的新引擎:新计算架构下的硬件、软件、服务,点燃了一个加速生成式 AI 应用的新生态:

硬件上,新 Blackwell 架构 GPU 组成的 GB200「新核弹」,将提供 4 倍于 Hopper 的训练性能,大模型参数达到了万亿级别。

软件层面,NIM「数字盒子」,让企业能更简单的在英伟达平台上定制大模型;Omniverse 将机器人、无人驾驶和数字孪生的训练和应用融合在一个平台之中。

从这次发布会,你可以看到英伟达一方面通过「新 AI 核弹」稳固自己「生成 AI 算力基建」的地位;另一方面通过 NIM、Omniverse 进一步扩大产业链下游,力求将自己的客户——大模型公司——逐渐管道化;同时利用 Thor+ Omniverse 成为数字孪生、无人驾驶以及机器人等新兴行业最重要的基础平台。

在发布预测天气的 Earth-2 模型时,黄仁勋背后出现了一张地球的卫星图片。「他的野心一直都是整个地球,无论是物理的,还是虚拟的。」喜欢瞎猜的人,可能会写下这样的图注。

Blackwell,专为 Transformer 而生

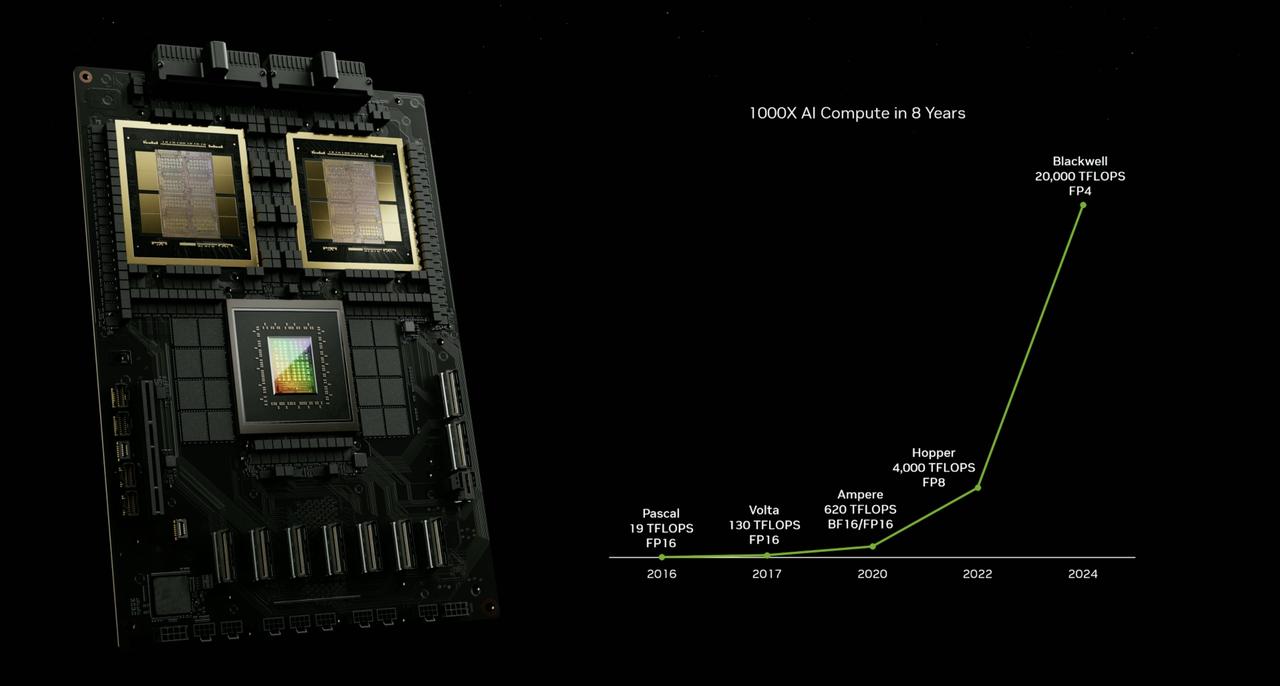

过去10年,随着AI的代际发展,英伟达提供所需算力的速度也在加快。

现在,生成式 AI 时代,英伟达计算平台进入下一个周期——Blackwell。这一新架构是继两年前推出的 Hopper 架构以来的全新架构。

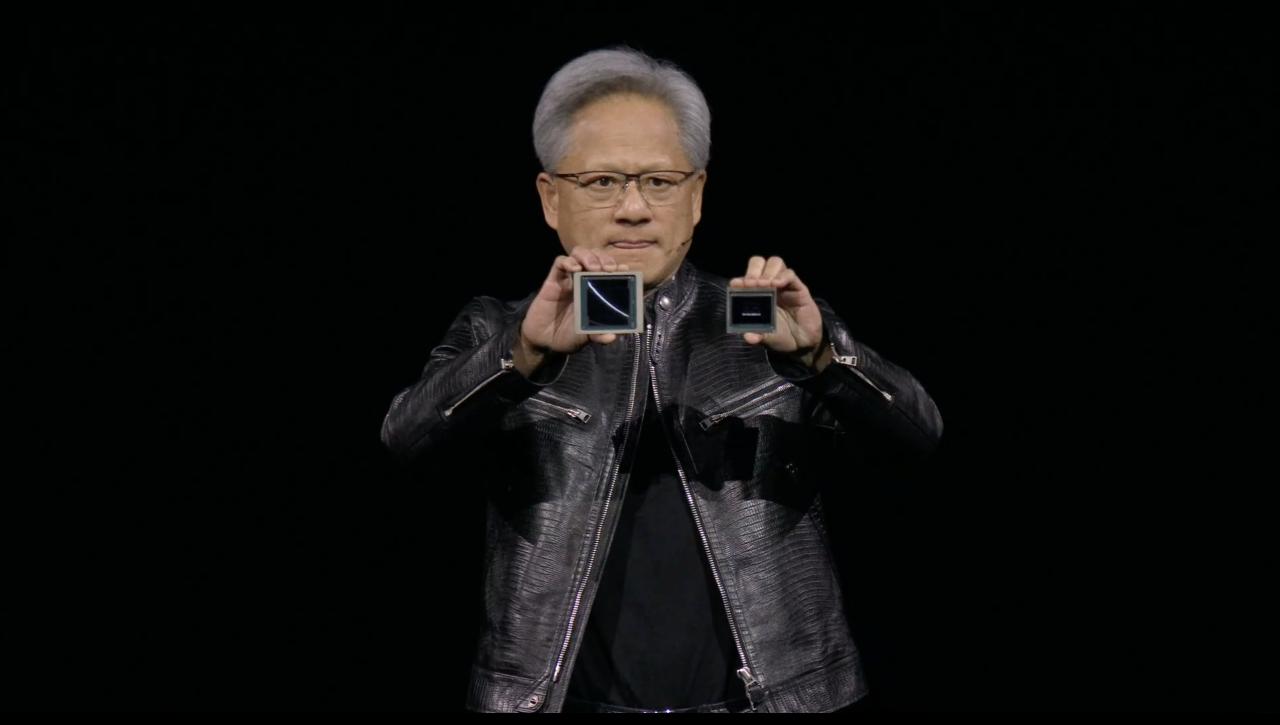

黄仁勋在台上介绍新架构芯片的优势时打趣道:「这是 Blackwell(左边),这是 Hopper(右边),Hopper 没关系,你的表现也很好」。|图片来源:Nvidia

与之前的 Hopper GPU 一样,Blackwell GPU 将作为独立 GPU 提供,或者两个 Blackwell GPU 可以组合并与英伟达的 Grace CPU 配对,创建一个超级芯片 GB200。

GB200 同过去架构的 AI 芯片性能对比|图片来源:Nvidia

作为一个超大规模的芯片,GB200 通过 900GB/s 超低功耗的片间互联,将两个 B200 GPU 与 Grace CPU 相连。

英伟达表示,该系统可以部署 27 万亿参数的模型。这甚至比最大的模型(例如 GPT-4)还要大得多,据报道 GPT-4 有 1.7 万亿个参数。

为了实现超高的 AI 性能,搭载 GB200 的系统可与英伟达 Quantum-X800 InfiniBand 和 Spectrum-X800 以太网平台连接。这两个平台均可提供速度高达 800Gb/s 的高性能网络。

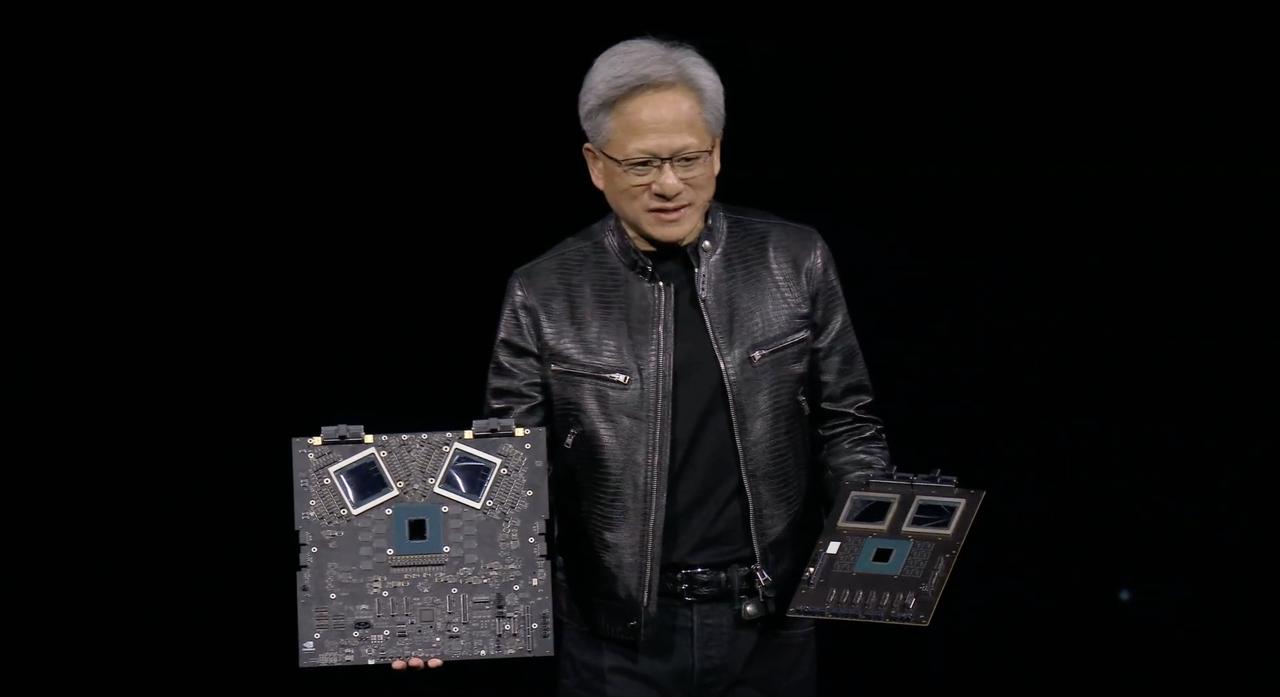

黄仁勋手捧两种 Blackwell 架构解决方案说「我得小心点,这个值多少钱,100 亿美元?当然第二块就便宜了,50 亿吧。」|图片来源:Nvidia

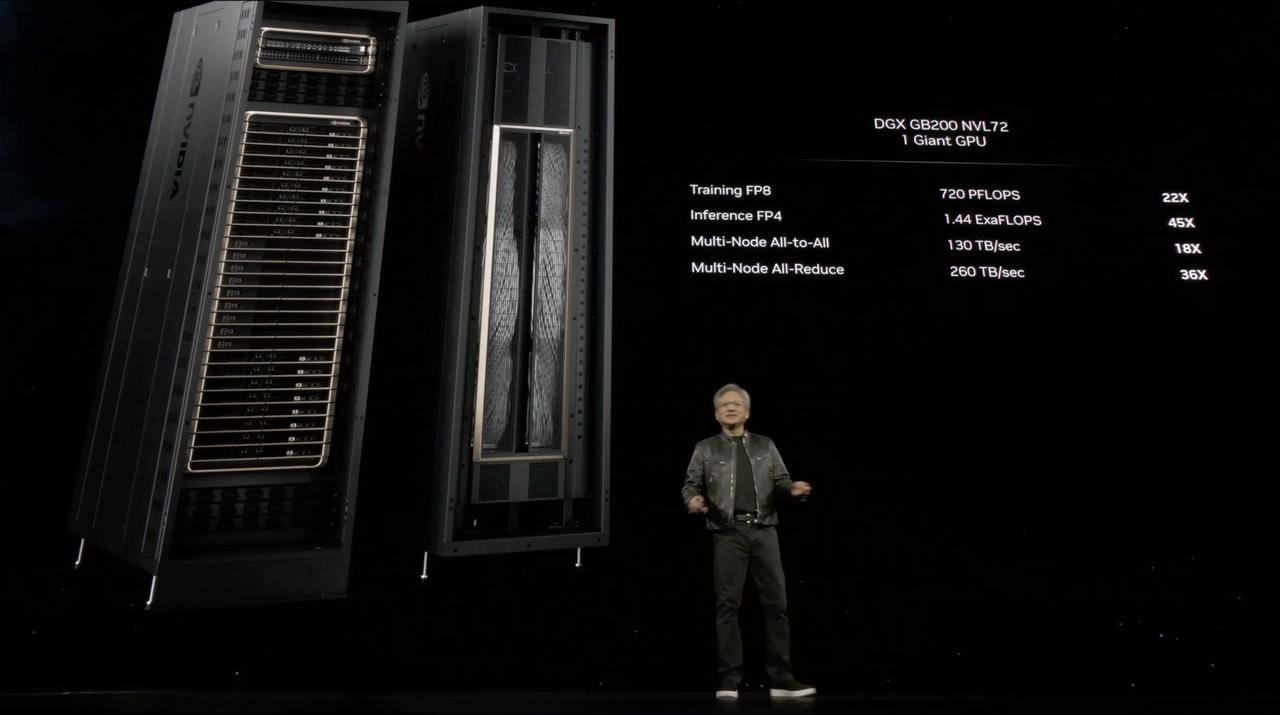

DGX GB200 的数据性能爆表|图片来源:Nvidia

Nvidia 还发布了 GB200 NVL72 液冷机架系统,其中包含 36 颗 GB200 Grace Blackwell Superchips。Nvidia 表示,与当前的 H100 GPU 相比,该系统的推理工作负载性能提高了 30 倍。

作为英伟达在 AI 训练和推理方面的新的顶级领导者,Blackwell GPU 和 GB200 超级芯片也将被引入云平台 NVIDIA DGX B200 系统中,用以模型训练、微调和推理。所有 NVIDIA DGX 平台均包含用于企业级开发和部署的 NVIDIA AI Enterprise 软件。

亚马逊,谷歌、微软和甲骨文将通过云服务出售 GB200 的访问权限。

定制大模型,更简单

数据显示,在这一波 AI 浪潮中,英伟达提供的 AI 算力可能达到了所有所需算力的 90% 甚至更高。而怎样才能卖出更多算力?显然是让更多企业用上大模型。

企业想要使用大模型,通常需要进行微调和私有化部署,才能对自己的企业的业务有所助益。而在目前,通常通过部署模型的云厂商或者小的服务商完成。

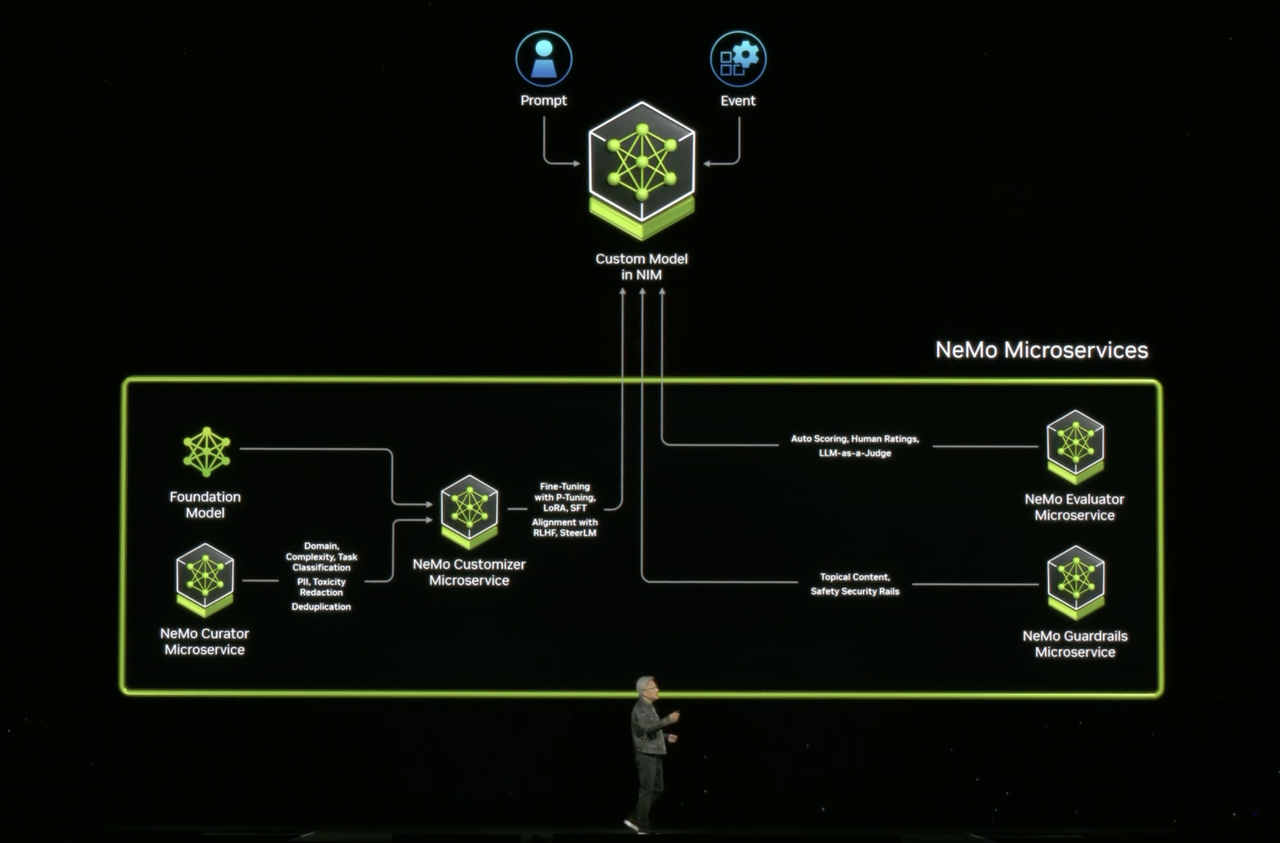

此次发布会上,英伟达则推出了自己的模型定制服务,Nvidia Inference Manager,简称 NIM,来实现有英伟达硬件的地方,就可以进行简单的调试使用大模型。

黄仁勋讲解 NIM |图片来源:Nvidia

NIM 被形容为一个数字盒子,在英伟达提供的网站下载即可使用。

盒子中包含几个要件。首先是基础大模型,有多种相关模型可供选择,黄仁勋提到其中包括开源模型如 Llama,来自合作伙伴的模型,也包括英伟达自己创建的一些模型——例如英伟达刚刚在 GTC 公布了一个新的天气预测模型。

按照英伟达的说法,它们都是根据英伟达硬件已经优化好的,无论你的硬件是笔记本电脑这样只有一块 CPU 的,还是公司级别有多个 GPU 节点的,都可以直接使用。

第二是可以帮助用户微调大模型的工具,这包含多项微服务。

比如,英伟达 2023 年 11 月宣布的 NVIDIA NeMo Retriever 技术,就被集成在整个的微服务中,可以帮助企业启用 RAG 功能——简单来说就是帮助企业更好地使用自己的专有数据。

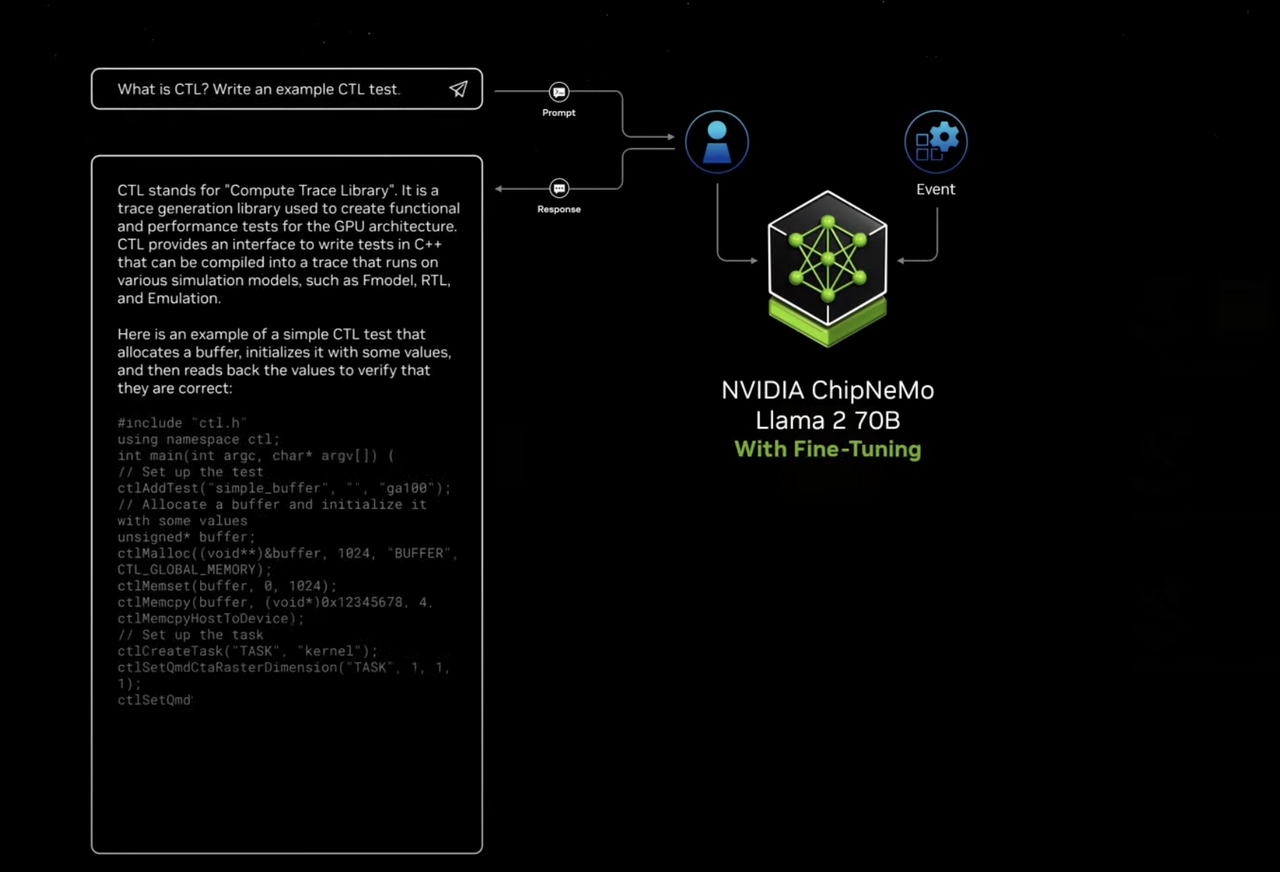

黄仁勋在演讲中举例子道:只下载了 Llama 2 模型时,他向 Llama2 提问公司独有的编程语言方面的问题,Llama 2 无法很好地回答。而将公司的私有数据提供给大模型之后,大模型不但能回答出这个问题了,还能够使用公司独有的编程语言进行编程了。

学习过公司数据的大模型可以很好地帮助企业提高效率 |图片来源:Nvidia

除了 RAG 增强,还有一系列的微服务可以帮助用户使用大模型。包括 Lemo 检索器,帮助信息的快速检索,数字人的微服务,帮助用户创建数字人等等。都包含在微服务中。

「未来我们将怎么构筑软件?应该不是一行行地写代码。」黄仁勋讲到,「很有可能是一个超级 AI 将任务分解,再交给一个一个的 NIM 去做。」

这样的 NIM,则可以被安装在任何英伟达硬件适配的地方。比如英伟达的 DGX 系统上,任何云上、企业私有的数据中心、或者是个人的硬件上。黄仁勋直接在演讲中说道:「我们是 AI 铸造厂。」

这项微服务,现在开发者可以免费试用。而企业则需要在企业软件订阅中,之前有消息称,每个 GPU 每年收取费用 4500 美元。

「现实 AI」:数字仓库和机器人

在推进算力和算力的使用上,英伟达是认真的。英伟达在二十年前就做出了 CUDA,推崇加速计算,今日的硕果累累来自于二十年前种下的因。

黄仁勋开场时回顾二十年前,半开玩笑地讲到:「当时我们已经算到了有今日。」

而黄仁勋看到的未来是什么样的呢?

在今天的 GTC 上,我们也小小地瞥见了一下黄仁勋眼中的未来:在世界的底层,是无限扩展的、不竭的算力,在中层,是数字孪生,是 simulation,是依靠算力带来的对物理世界的无限精准的模仿,实验和预测,而在上层,则是一个依靠算力达到最优解的世界——在这个世界里,人与机器人共生。一切第一次发生的,都是发生过无数次的。

这其中,英伟达 2021 年开始推出的 Omniverse,就是中间层非常重要的工具。

Omniverse 是英伟达擅长的计算机图形、人工智能、科技计算和物理模拟真正大一统的平台,能够对环境实现 1:1 的数字孪生。

此次发布会,结合人工智能的浪潮,Omniverse 展现了许多新的应用可能。

Omniverse 可以为现在最火的具身智能,提供一个训练场所。英伟达表示,英伟达建立了 Isaac Lab,一款机器人学习应用程序,用于在 Omniverse Isaac 模拟器上进行训练。通过新的计算编排服务,可以在基于物理的模拟中训练机器人,并能零次训练(zero-shot)迁移到实际环境。

机器人模型将使机器人能够从少量人类演示中学习,从视频中理解人类、在模拟中训练模型,并最终直接部署到物理机器人上。

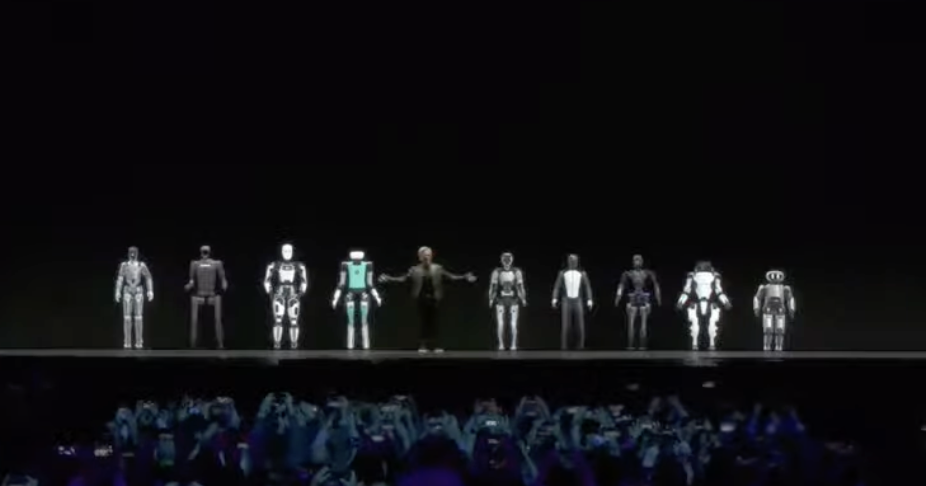

黄仁勋还在发布会上宣布了 Project GR00T 项目,GR00T 是一个用于人形机器人的通用基础模型,基于 Jetson Thor(英伟达的一款GPU)来开发生产机器人。

黄仁勋与人形机器人「站在一起」,其中部分机器人来自中国公司|图片来源:Nvidia

除此之外,英伟达还展示了一个数字仓库的案例。

数字仓库感知和规划了人和机器人的路线|图片来源:Nvidia

视频中,展示了一个一个 10 万平方英尺仓库的 Omniverse 模拟环境,它整合了运行视频、Isaac 感知器堆栈的数字工人 AMR、来自 100 个模拟天花板安装摄像头的整个仓库的集中活动地图等。

在视频中,一个数字工人 AMR 的原定计划的路线上,发生了一起事故,路径受阻。英伟达 Metropolis 可以实时改变路径规划。通过基于生成式 AI 的 Metropolis 视觉基础模型,操作员甚至可以使用自然语言提问发生了什么事情。

在此次 GTC 上,英伟达宣布,将创建 Omniverse Cloud 的 api,而且将非常易用,企业可以更容易地使用 Omniverse,同时其中还将有 AI 的能力。比如可以直接用自然语言场景描述,创建仿真环境的 3D 图像。

同时,英伟达宣布与 Vision Pro 达成合作,Omniverse Cloud 将能够向 Vision Pro 串流。「从虚拟车上下来,穿过车门的感觉,非常奇怪,但也非常棒。」黄仁勋讲到,「Vision Pro 将把你带入 Omniverse Cloud,你能够体验到的工作流是无与伦比的。」

超过 1 万人在现场观看 Keynote,900 场以上的分享以及数百家展商,2024 年 GTC 被戏称为「AI 界的伍德斯托克」——除了苹果公司,少有公司能让科技变成一种人人想要「沾上边」的时尚。毕竟,在「生成式 AI」代表未来的当下,每个人都想成为那个跟上潮流的人。

英伟达无疑是那个潮流背后最大的推手之一,同时也是目前最大的受益方,它需要做的,是为所有人提供更大的梦想,和更多的算力。顺便,或许,成为全球市值最高的公司,没有之一。

最新评论

苹果如果不支持微信,那它就是要退出中国市场了!

自己花钱买的座位,凭什么不能换?

不得不说蓝心妍很漂亮,我喜欢!

人间胸器

去了美颜滤镜,估计就是大妈了!

期待,不过感觉自己可能用不上了!

天涯不是彻底关闭了吗?

感觉长想一般般!